Nextcloud unter der Lupe: Wie der ELK-Stack aus Datenströmen Erkenntnisse schmiedet

Es ist ein klassisches Szenario: Die Nextcloud läuft. Benutzer synchronisieren Dateien, teilen Links, nutzen Kalender und Talk. Oberflächlich ist alles ruhig. Doch dann meldet sich die Marketing-Abteilung: „Der Upload der großen Videodatei gestern hat ewig gedauert.“ Einzelne Nutzer berichten von sporadischen Zeitfehlern im Kalender. Die Festplattenfüllung schreitet schneller voran als prognostiziert. Wo setzt man an? Die Standard-Logdateien von Nextcloud, Apache oder PHP-FPM sind schnell ein unüberschaubarer, mehrgigantischer Textdschungel. Man braucht eine Strategie, keine Nadel im Heuhaufen.

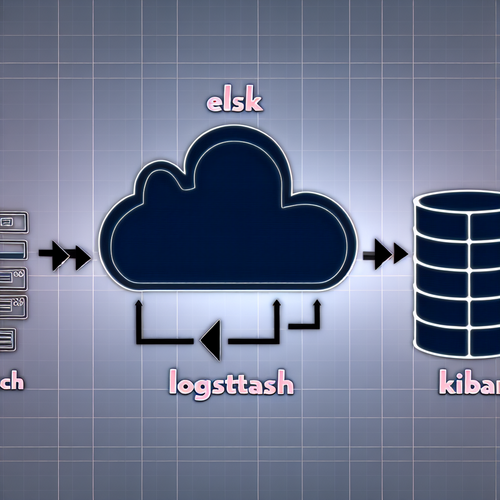

Hier kommt der ELK-Stack ins Spiel – oder präziser: der Elastic Stack. Dieses Trio aus Elasticsearch, Logstash und Kibana hat sich zum De-facto-Standard für die zentrale Erfassung, Analyse und Visualisierung von Log- und Metrikdaten entwickelt. Die Integration mit Nextcloud ist keine vorgefertigte One-Click-Lösung, sondern ein spannendes Infrastrukturprojekt, das Transparenz in einer völlig neuen Dimension schafft. Es geht nicht um bloße Fehlersuche, sondern um die Etablierung einer datengestützten Betriebskultur.

Vom Datenchaos zur strukturierten Erkenntnis: Die Rolle des Elastic Stack

Bevor wir uns die Hände mit konkreten Konfigurationsdateien schmutzig machen, lohnt ein Blick auf das Werkzeug. Der Elastic Stack ist weniger ein einzelnes Programm, mehr eine hochspezialisierte Pipeline für Informationen. Jede Komponente hat eine eindeutige Aufgabe.

Elasticsearch ist das Herzstück, eine verteilte Such- und Analysemaschine auf Basis von Lucene. Man kann sie sich als eine extrem leistungsfähige, skalierbare Datenbank vorstellen, die nicht nur speichert, sondern sofort durchsuchbar und aggregierbar macht. Sie indiziert jeden Logeintrag, jede Metrik.

Logstash agiert als mächtiger Datenknecht. Es nimmt Rohdaten aus beliebigen Quellen – Logdateien, Systemmetriken, Datenbanken –, parst sie, strukturiert sie und reichert sie gegebenenfalls an, bevor es sie an Elasticsearch weiterleitet. Hier findet die Magie der Transformation statt: Aus einer Zeile wie 10.0.1.45 - - [15/Oct/2024:14:23:12 +0200] "PUT /remote.php/dav/files/alice/Dokumente/report.pdf HTTP/1.1" 201 5432 werden separate Felder für IP, Zeitstempel, HTTP-Methode, Benutzer, Dateipfad, Statuscode und übertragene Bytes.

Kibana schließlich ist das Gesicht des Stacks. Diese Weboberfläche erlaubt es, die in Elasticsearch liegenden Daten in Echtzeit zu durchsuchen, zu analysieren und in maßgeschneiderten Dashboards zu visualisieren. Hier entstehen die live-Karten der Systemauslastung, die Histogramme der Zugriffsfehler oder die Nutzungsstatistiken pro Abteilung.

Für Nextcloud bedeutet das: Die verteilten Log-Informationen aus Web-Server, PHP-Anwendung, Datenbank und sogar des darunterliegenden Betriebssystems werden in einem zentralen, durchsuchbaren System vereint. Korrelationen werden plötzlich sichtbar: Fällt der Upload-Durchsatz immer dann ab, wenn ein bestimmter Cron-Job läuft? Gehen die PHP-Fehler mit Spitzen bei der Datenbanklast einher? Diese Fragen lassen sich mit isoliertem Logging kaum beantworten.

Nextcloud vorbereiten: Logging jenseits der Standardeinstellungen

Nextcloud selbst bietet im Administrationsbereich unter „Diagnose“ zwar eine Übersicht über Logeinträge, diese ist für die tiefgehende Analyse jedoch unzureichend. Der erste Schritt ist daher, das interne Log-Level zu erhöhen und die Ausgabe zu strukturieren. Interessanterweise hat Nextcloud hier in den letzten Jahren stark nachgebessert.

In der config.php sollten Sie das Log-Level mindestens auf 1 (Info) setzen, für Debug-Zwecke auch auf 0 (Debug). Entscheidend ist jedoch der Wechsel vom menschenlesbaren Format zum maschinenlesbaren JSON. Diese Einstellung ist ein Game-Changer für die spätere Verarbeitung durch Logstash.

'log_type' => 'file',

'logfile' => '/var/log/nextcloud/nextcloud.log',

'loglevel' => 1,

'log.condition' => [

'shared_secret' => 'IhrGeheimerSchlüssel', // Für Remote-Logging via syslog

],

'log.format' => 'json', // Wichtig für strukturierte VerarbeitungPlötzlich enthält jeder Logeintrag bereits strukturierte Felder: reqId für die eindeutige Zuordnung einer Nutzeranfrage über mehrere Logzeilen hinweg, user, app, message, level und time. Das Parsen in Logstash wird dadurch erheblich vereinfacht und robuster.

Ein weiterer, oft unterschätzter Datenquell ist der Audit-Log von Nextcloud. Dieser protokolliert explizit sicherheitsrelevante Ereignisse wie Dateizugriffe, geteilte Links, Anmeldungen und Berechtigungsänderungen. Für Compliance und forensische Untersuchungen ist er unverzichtbar. Auch dieses Log lässt sich im JSON-Format ausgeben und in den ELK-Stream einspeisen. Dabei zeigt sich ein Vorteil der Eigenentwicklung: Die Granularität der Nextcloud-Logs ist deutlich höher als bei generischen Webanwendungen.

Die Pipeline bauen: Logstash als kreativer Übersetzer

Nun wird es konkret. Logstash benötigt eine Konfigurationsdatei, typischerweise in /etc/logstash/conf.d/, die drei Abschnitte definiert: Input, Filter und Output. Für Nextcloud wird man oft mehrere solcher Konfigurationen für verschiedene Datenquellen parallel betreiben.

Der Input für die Nextcloud-JSON-Logs kann einfach ein Dateipfad sein. Eleganter ist jedoch die Nutzung von Filebeat, einem schlanken Agenten der Elastic-Familie, der Dateien ausließt und die Daten effizient an Logstash oder direkt an Elasticsearch streamt. Das entlastet Logstash und ist ressourcenschonender.

Der Filter-Abschnitt ist die eigentliche Denkfabrik. Hier wird der rohe JSON-String geparst. Dank des JSON-Formats von Nextcloud ist der zentrale Befehl simpel:

filter {

if [type] == "nextcloud-app" {

json {

source => "message"

}

# Zeitstempel aus dem Nextcloud-Log wird zum offiziellen @timestamp von Logstash

date {

match => [ "time", "ISO8601" ]

}

# Benutzerfeld bereinigen, falls anonym

if [user] == "--" {

mutate {

remove_field => [ "user" ]

}

}

}

}Für die Webserver-Logs (Apache oder nginx) wird es komplexer. Hier kommt der grok-Filter zum Einsatz, ein mächtiges Werkzeug mit einer eigenen Regex-ähnlichen Syntax, um unstrukturierte Textzeilen in Felder zu zerlegen. Es gibt vordefinierte Patterns für gängige Logformate, die man anpassen muss. Ein Fehler im grok-Pattern lässt die gesamte Pipeline scheitern – stetes Testen ist hier Pflicht.

Der Output leitet die nun bereinigten und angereicherten Daten schließlich an Elasticsearch weiter, wo sie in einem Index landen, den man z.B. nextcloud-logs-2024.10 nennen könnte. Indizes werden typischerweise pro Tag oder Monat angelegt, was die Verwaltung und Aufbewahrungspolitik vereinfacht.

Ein interessanter Aspekt ist die Anreicherung: Logstash kann externe Daten hinzufügen. So ließe sich eine IP-Adresse aus dem Access-Log gegen eine interne Liste halten, um Zugriffe aus der Forschungsabteilung automatisch zu kennzeichnen. Oder der Nextcloud-Benutzername wird mit dem tatsächlichen Namen aus einer LDAP-Datenbank angereichert. Diese Kontextualisierung erhöht den analytischen Wert enorm.

Dashboards, die sprechen: Kibana als Kommandozentrale

Mit den Daten in Elasticsearch erwacht Kibana zum Leben. Nachdem die Index-Pattern definiert sind, beginnt die eigentliche, fast schon spielerische Arbeit: das Bauen von Visualisierungen und Dashboards. Für einen Nextcloud-Admin ergeben sich naheliegende und mächtige Ansätze.

Ein Operationelles Dashboard überwacht die Systemgesundheit. Hier finden sich Echtzeit-Diagramme zu HTTP-Statuscodes (wie viele 200 OK vs. 500 Internal Server Error?), Antwortzeiten der Nextcloud-API-Endpunkte, Datenbankabfragezeiten und Systemlast des Servers. Eine plötzliche Häufung von 5xx-Fehlern schlägt sofort visuell aus.

Das Nutzungs-Dashboard richtet den Blick auf die Anwender. Welche Apps (Datei, Kalender, Talk, Deck) werden am häufigsten genutzt? Wie verteilt sich die Speichernutzung über die Organisations-Einheiten? Gibt es „Power-User“, die ungewöhnlich viele Dateien teilen oder eine exorbitante Upload-Volumen generieren? Diese Erkenntnisse sind goldwert für Kapazitätsplanung und Schulungsbedarf.

Besonders spannend wird es im Sicherheits- und Audit-Dashboard. Hier werden alle Anmeldeversuche (erfolgreich und gescheitert) nach IP und Uhrzeit aufgelistet. Ungewöhnliche Zugriffszeiten oder Zugriffsversuche von geografisch auffälligen Regionen fallen sofort auf. Die Aktivitäten im Audit-Log – wer hat welche Datei wann heruntergeladen, wer hat einen geteilten Link deaktiviert – werden durchsuchbar und visualisierbar. Für die Einhaltung der DSGVO ist das ein starkes Werkzeug.

Kibana erlaubt es auch, anomaly detection mit Machine-Learning-Algorithmen zu nutzen. Das System kann lernen, was ein „normales“ Zugriffsmuster auf die Nextcloud ist, und alarmieren, wenn es davon abweicht – etwa bei einem nächtlichen Datenexport durch einen Benutzer, der sonst nur werktags arbeitet.

Praktische Tipps aus der Werkstatt: Fallstricke und Optimierungen

Die Theorie klingt überzeugend, die Praxis bringt Hürden. Einige Erfahrungswerte können Kopfschmerzen ersparen. Zuerst die Ressourcenfrage: Der Elastic Stack ist nicht leichtgewichtig. Elasticsearch ist speicherhungrig, da es einen Großteil seiner Indizes im RAM hält, um Geschwindigkeit zu bieten. Für eine produktive Nextcloud-Instanz mit mehreren hundert Nutzern sollten Sie mindestens 8 GB RAM für den gesamten Stack einplanen, besser 16 GB. Logstash kann bei hohem Logaufkommen zur CPU-Falle werden – die Filter müssen effizient sein.

Index-Lifecycle-Management (ILM) ist ein Muss. Sie wollen nicht, dass Ihre Elasticsearch-Instanz in einem Jahr an eigenen Logdaten erstickt. Definieren Sie eine Politik: Logs kommen einen Monat in einen „heißen“ Index auf schnellen SSDs, danach für zwei weitere Monate in einen „warmen“ Index auf günstigerem Speicher, bevor sie automatisch gelöscht werden. Das hält die Performance hoch und die Kosten kontrollierbar.

Ein häufiger Fehler ist das „Logging um des Loggings willen“. Jedes zusätzliche Feld, jeder komplexe Filter kostet Leistung. Fragen Sie sich: Brauche ich wirklich das vollständige User-Agent-String in jedem Log? Oder reicht die Information „Browser: Chrome, OS: Windows“? Aggregationen in Logstash können das Datenvolumen drastisch reduzieren.

Vergessen Sie nicht die Nextcloud-Cron-Jobs und Hintergrunddienste. Die Ausgabe von occ files:scan oder occ background:cron enthält wertvolle Informationen über Performance-Probleme im Dateisystem oder bei der E-Mail-Benachrichtigung. Diese Logs sollten ebenfalls in die Pipeline eingespeist werden. Oft sind es diese Hintergrundprozesse, die bei Skalierungsproblemen als erstes stolpern.

Ein letzter, wesentlicher Punkt: Sicherheit. Der Elastic-Stack selbst muss abgesichert werden. Elasticsearch sollte nie ohne Authentifizierung im Netz hängen. Nutzen Sie die kostenlosen Security-Features von Elastic, um Zugriff mit Benutzername/Passwort oder Client-Zertifikaten zu regeln. Ihre gesamten Logdaten sind ein sensibler Datenschatz – sie verraten nahezu alles über das Nutzerverhalten in Ihrer Nextcloud.

Die Synergie: Mehr als die Summe der Teile

Was bringt dieser erhebliche Aufwand nun konkret? Es ist die transformative Wirkung auf den Betrieb. Aus dem reaktiven Feuerwehr-Modus („Warum ist es gerade langsam?“) wird ein proaktives, prädiktives Management („Die Datenbankantwortzeiten steigen wöchentlich um 5%, in drei Wochen brauchen wir einen Optimierungsschritt“).

Probleme können isoliert werden. Ein Nutzer beschwert sich über langsame Synchronisation. Statt im Dunkeln zu tappen, suchen Sie in Kibana nach seiner Benutzer-ID, filtern den Zeitraum und sehen sofort: Alle seine Anfragen an den WebDAV-Endpunkt /remote.php/dav weisen hohe Latenzen auf, während andere Endpunkte flott sind. Die Korrelation mit den Systemmetriken zeigt: Die CPU-Auslastung ist in Ordnung, aber die I/O-Wartezeiten der Festplatte sind genau in diesen Momenten hoch. Die Ursache könnte ein paralleler großen Datei-Upload eines anderen Nutzers sein – ein Problem der Ressourcenfairness, das sich durch gezielte Rate-Limiting in Nextcloud lösen ließe.

Nicht zuletzt dient die ELK-Integration auch der Rechtfertigung von Investitionen

Die Kombination aus Nextcloud, einer quelloffenen, datensouveränen Kollaborationsplattform, und dem Elastic Stack, dem mächtigsten Open-Source-Tool für Operational Intelligence, schafft eine bemerkenswerte Unabhängigkeit. Sie sind nicht mehr auf undurchsichtige Cloud-Analyse-Dienste oder teure proprietäre Monitoring-Suiten angewiesen. Sie behalten die Kontrolle über Ihre Daten – sowohl die Nutzungsdaten als auch die Metadaten über deren Nutzung.

Fazit: Der lohnende Blick in den Spiegel

Die Integration von Nextcloud mit dem ELK-Stack ist kein Projekt für einen Nachmittag. Es erfordert Planung, Einarbeitung und kontinuierliche Pflege. Doch der Ertrag ist ein tieferes, fundierteres Verständnis der eigenen digitalen Infrastruktur, wie es mit oberflächlichen Monitoring-Tools nie zu erreichen ist.

Man installiert sich gewissermaßen einen hochauflösenden Spiegel vor die eigene Nextcloud. Jeder Zugriff, jeder Fehler, jedes Leistungsmerkmal wird sichtbar, analysierbar und damit beherrschbar. In einer Zeit, in der digitale Kollaboration zur Lebensader von Organisationen wird, ist diese betriebliche Souveränität kein Nice-to-have mehr, sondern eine Kernkompetenz für IT-Abteilungen. Die Tools dazu sind frei verfügbar. Es liegt nun an den Admins, sie klug einzusetzen und aus den Datenströmen jene Erkenntnisse zu schmieden, die eine stabile, performante und sichere Nextcloud-Infrastruktur gewährleisten.

Der Weg lohnt sich. Nicht nur für die Nextcloud, sondern als Blaupause für die Transparenz der gesamten IT-Landschaft. Wer einmal erlebt hat, wie Kibana-Dashboards in der Team-Besprechung die Diskussion versachlichen und beschleunigen, will die blinden Flecken nicht mehr zurück. Es ist ein Schritt weg vom Fühlen im Dunkeln, hin zum Lenken mit Klarheit.